ディストリビューションとAI戦略②:OpenAI vs Anthropic

前回に引き続き分析を続ける。LLM直販組とは書いたが、このカテゴリの圧倒的リーダーはOpenAIなので、とりあえずOpenAIの分析をする。

OpenAI:広告をやらないのか?できないのか?

先週Sam AltmanとのインタビューでBen Thompsonも指摘していたが、ChatGPTはFacebook以来の世界規模BtoCサービスである。その週次ユーザー数は4億人を超え、世界第6位のトラフィックを誇る。2024年の売上は$3.7B(≒5,500億円)を超え、今年の売上はその3倍を超える$11.6B(1兆7,000億円)と予想されている。

こうやって書くとものすごい大きな数字のように思える。しかし売上規模世界最大のSaaS企業Salesforceと比べると1/3以下であり、いわゆるMagnificent 7と比べるならば、もっとも売上が小さいTeslaの1/10程度にとどまる。成長スピードは脅威的であれど、決して効率の良い稼ぎ方をしているようにはみえない。

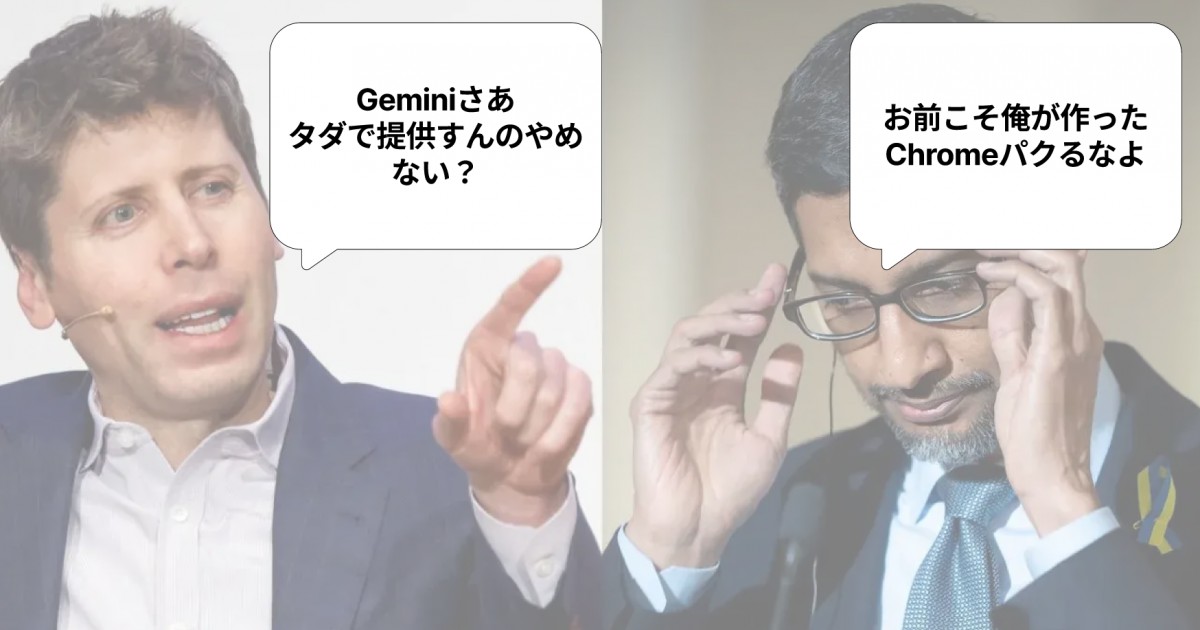

効率良い稼ぎ方については既に模範解答が出ており、それは広告である。これまたBen Thompsonが2024年初頭からStratecheryで指摘してきたが、少なくとも先週の段階ではSam Altman氏は広告による収益化に懐疑的であるようにみえる。Altman氏は広告から得られる収入よりも、ソフトウェアエンジニアリングを代行できるエージェントを売る方がポテンシャルが大きいと考えていることが、インタビューのやり取りからもみてとれる。

GTMの重力は二つある。一つは既存ビジネス、もう一つは経営陣の価値観である。良くも悪くもChatGPTは先にサブスクビジネスで軌道に乗ってしまった。サブスクビジネスが軌道に乗っているということは、社内の誰かの指標が課金率であるはずで、その人からすれば広告プロダクトの展開は自身のゴール達成の障壁となるし、なんだったら短期的には売上が下がる可能性すらある。ご存知の通りOpenAIは大赤字であり、2024年には7,500億円近くの損失を出したと言われている。そんな中で唯一のマネタイズチャネルに小さくない影響を与える取り組みに対して躊躇するのは何ら不思議ではない。

広告とサブスクは時間軸において可換ではない。元々広告でマネタイズしていたプロダクトが、広告を消す方法としてサブスクを提供する場合、それは課金化へのトリガーとなる。YouTubeが好例で、クソみたいなスマホゲームの広告を見ないで済むためにサブスク契約をする人が一定数いるということは、YouTubeサブスクの売上が$14.5Bまで成長している事実が証明している(つまりYouTubeサブスクの方がOpenAIよりもビジネスとして大きいということになる)。しかしOpenAIのように先にサブスク製品を展開してしまっている場合、無償ユーザーへの広告表示は既存顧客の製品体験悪化につながるうえ、今のLLM as a Service業界はフリーミアムがデファクト化しているため、「OpenAIの広告ウザいからDeepSeekにするか」みたいにユーザーの流失につながる可能性もゼロではない。何より、広告ビジネスをやるとなるとそのための営業部隊も立ち上げる必要があり、今のOpenAIにそれができるゾス精神があるようにも思えない。

Altman氏自身に広告の経験がないこと、そしてCOOのBrad Lightcap氏に特筆すべきビジネスの経験がないことも大きな理由だろう。加えて同社のGTMリーダー陣は決して強いとは言えない。COOのBrad Lightcap氏は金融畑の人間で、OpenAIに入社するまでのオペレーターとしての経験は、DropboxでM&A要員として過ごした一年半のみである。10ヶ月前にChief Commercial Officerとして入社したGC Lionetti氏も、SEおよびプロダクトマーケティングあがりのリーダーであり、法人営業の経験は豊富とは言えない。プロダクトが強い企業ならではの人選だとは思うが、裏を返せば現在の布陣で広告ビジネスを始めるのは現実的ではないように思う。

そうなるとやはりAltman氏の言うようにユーザーを一刻も早く増やし、さらにARPUを向上させるしかないのだが、現在のLLM as a Serviceはコモディティ化の流れが強い。その流れに逆らったプレミアム価格を守り抜くことは決して安易ではないだろう。

Anthropic:選択と集中

業界リーダーのOpenAIがホールプロダクト戦略を突き進める一方で、万年二番手のAnthropicは気持ち良いほどに選択と集中を実践している。前回も述べたようにAmazon Web Servicesから全面的なバックアップを受け、一にも二にも開発者ユーザーを優先するロードマップを敷いてきている。実際開発者ユーザーの間ではClaudeの評判はすこぶる良く、CursorやWindsurf、Clineといったコーディングエージェントから呼び出すならClaudeが最適だという共通理解が進みつつある。

興味深いことに、少なくともArtificial Analysisが発表しているベンチマークと照らし合わせると、Claudeの優位性はあくまでユーザーの定性的評価に基づいたものであることが一目でわかる。コストという観点で言えば、OpenAIがAPIを出し惜しみしていたo3モデルや、中国発のオープンウェイトモデルの方がコスパが良い。

ではなぜClaudeの人気が根強いかというと、そもそもClaudeが比較されてきたのはo3以前のGPT-4oだからだというのが当ニュースレターは分析する。下のArtificial Analysisからもわかるように、GPT-4oはコスト面ではClaude 3.5 Sonnetに辛勝するも、ついぞコーディング能力に関しては負け越すこととなった。GPT-4oが発表荒れた2024年5月からo3が発表される翌年2月までの9ヶ月間は、コーディングに強いLLMというClaudeのブランドを確立するには十分すぎる時間であったというわけだ。

この半年で価格破壊が進みすぎてしまったため、昨年発表されたモデルはどれも二軍落ちである

Anthropicの開発者フォーカスは徹底している。明らかにCursorやWindsurfといった開発者向けツールを意識したClaude Codeもさることながら、GTMのリーダー陣営をStripeの出身者たちで固めるなど、開発者起点のプラットフォームセールスに振り切っている。デスクトップアプリがElectron製でやる気がないと批判されたところで、そもそも消費者向け市場で勝負する気がないので問題ではない。

OpenAIの暖簾分けから始まったAnthropicなので、当然の如くOpenAIの強みも弱みも把握しているはずだ。そしてOpenAIの弱みは、非営利団体という出自に起因する経営基盤の不安定さでも、Microsoftにエンプラ販路を握られていることでもない。ウェブサービスとして成功してしまったことに起因する、プラットフォーム商売に対するコミットメントの弱さである。

* We will only ever be able to build a small fraction of the AI products the world needs

* Having a product like ChatGPT helps us stress test our models in 100 ways, resulting in

今月11日Responses APIを発表した際、一部のユーザーからOpenAIはモデル提供企業なのかプロダクト企業なのかとのX上で疑問の声が上がった。昨年6月CPOに着任したKevin Weil氏は、どっちなのという質問に対して「両方」だと答えている。興味深いのはその裏付けだ。「既に4億人が毎週ChatGPTを使っているから」プロダクト企業である一方、「世界が必要とする全てのAIアプリを自社では作れない上、ChatGPTという巨大サービスを介してモデルの負荷テストを行うことで、より良いモデルを開発者に提供できるから」モデル提供企業でもあるというロジックだ。

さすがは旧TwitterとInstagramでプロダクトのトップを歴任した御仁である。その自信みなぎる発言を受けてなるほどその通りだと思ってしまいそうになるが、GPTのマーケットプレイスを作って開発者と売上シェアを始めるよと発表してから18ヶ月、GPTsは実質オワコン化している。当初約束されていた売上シェアの話も一年前から音沙汰がない。小さな約束を破る会社は大きな約束も破るということを開発者は身をもって理解している。Bill Gatesの言葉を借りるならば、「ユーザーが享受する経済的価値が、プラットフォーム自身が得る経済的利潤を凌駕してこそプラットフォームはプラットフォームたり得る」のだ。そういう意味では、API売上がサブスク売上をはるかに上回るAnthropicの方が、OpenAIよりもプラットフォームと呼ぶに相応しいだろう。(まあそれでもOpenAIのAPI収益の方が、Anthropic全体の売上よりも大きいくらいには差がついてしまっているのだが…)

昨日発表されたOpenAI Agents SDKによるModel Context Protocol(MCP)サポートは、そういう意味でも象徴的な出来事であった。昨年11月末にAnthropicが発表したMCPは、大規模言語モデルでも、アプリケーション機能でもなく、LLMが外部サービスを呼び出す際のインターフェース仕様でしかない。しかしAnthropicがそのプロトコルを公開し、自社サービスであるClaudeで採用したことがきっかけとなり、外部の開発者がこぞってMCP対応を開始、ついにOpenAIもサポートせざるを得なくなった。

MCP自体はAnthropicに直接的な優位性をもたらすものではない。しかしMCPがLLMと外部コンテクストとの共通インターフェースとなることで、OpenAIによる開発者ロックインは難しくなる。LLM as a Service間での代替コストが低ければ低いほどありがたい開発者の間では、これを機にさらにAnthropicファンが増えるのではなかろうか。

最後にDeepSeekであるが、これに関しては地政学的観点も織り交ぜながら、第3部として分析することとしたい。

すでに登録済みの方は こちら